Sztuczna inteligencja i Geoffrey Hinton: ojciec "głębokiego uczenia się"

Source:

Source:

Sztuczna inteligencja. Ile się o nim mówi, a przecież możemy nawet mówić jeszcze dobrze nie zaczęli. Prawie wszystko, co można usłyszeć o postępie sztucznej inteligencji, opiera się na przełomie, który trzydzieści lat. Utrzymanie tempa postępu wymaga unikania poważnych ograniczeń poważnych ograniczeń. Dalej od pierwszej osoby — James Somers.

Stoję tam, gdzie wkrótce będzie centrum świata, lub po prostu w dużym pokoju na siódmym piętrze błyszczące wieże w centrum Toronto — z której strony spojrzeć. Mnie towarzyszy Jordan Jacobs, współzałożyciel tego miejsca: Instytut Wektor, który jesienią tego roku otwiera swoje drzwi i obiecuje stać się globalnym centrum sztucznej inteligencji.

Jesteśmy w Toronto, bo Geoffrey Hinton w Toronto. A Geoffrey Hinton — ojciec "głębokiej nauki, techniki, leżącej szczytu na temat AI. "Przez 30 lat spojrzymy wstecz i powiedzieć, że Jeff — Einstein dla AI, głębokiej nauki, wszystkiego, co nazywamy sztuczną inteligencją", mówi Jacobs. Z wszystkich badaczy AI Hintona cytują częściej niż trzech idących za nim, razem wziętych. Jego studenci i doktoranci odchodzą do pracy w laboratorium AI w Apple, Facebook i OpenAI; sam Hinton — wiodący naukowiec w zespole Google Brain AI. Praktycznie każde osiągnięcie w dziedzinie AI w ciągu ostatnich dziesięciu lat — w tłumaczeniu, rozpoznawania mowy, rozpoznawania obrazów i grach — tak czy inaczej dotyczy pracy Hintona.

Instytut Wektor ten pomnik wspinaczki pomysłów Hintona, jest ośrodkiem badawczym, w którym firmy z USA i Kanady — jak Google, Uber i NVIDIA — sponsorują wysiłki zmierzające do komercjalizacji technologii AI. Pieniądze wlewają się szybciej, niż by marc Jacobs ma czasu o tym zapytać; dwaj z jego założycieli byli zapytani firmy w zakresie Toronto, i popyt na ekspertów w dziedzinie AI był 10 razy wyższy, niż dostarcza Kanada każdego roku. Instytut Wektor w pewnym sensie непаханая целина dla próby zmobilizować świat wokół głębokiego uczenia się: aby inwestować w tę technikę, nauczyć się jej, doskonalić i stosować. Centra danych są budowane, wieżowce wypełnione startupami, w obszar wlewają się całe pokolenia studentów.

Kiedy stoisz na podłodze "Wektor", można odnieść wrażenie, że na początku czegoś. Ale głębokie szkolenia, w swej istocie, jest bardzo stary. Przełomowa artykuł Hintona, napisana razem z Davidem Румельхартом i Roland Williamsa, została opublikowana w 1986 roku. W pracy szczegółowo został metodę odwróconej propagacji błędów (backpropagation), "бэкпроп", w skrócie. Бэкпроп, według Johna Cohena, — to wszystko, na czym opiera się głębokie szkolenia — w ogóle wszystko".

Jeśli spojrzeć na root, dzisiaj AI — to głębokie szkolenia, a głębokie nauczanie — to бэкпроп. I to niesamowite, biorąc pod uwagę, że бэкпропу ponad 30 lat. Aby zrozumieć, jak to się stało, po prostu trzeba: jak technika mogłam czekać tak długo, a następnie stać się przyczyną wybuchu? Bo jak tylko poznasz historię бэкпропа, zdasz sobie sprawę, co się teraz dzieje z AI, a także i to, że możemy i nie stać na początku rewolucji. Może w końcu takie.

Spacer z Instytutu Wektora do biura Hintona w Google, gdzie spędza większość swojego czasu (teraz emerytowany profesor Uniwersytetu w Toronto) — jest to swego rodzaju żywa reklama dla miasta, przynajmniej w lecie. Staje się jasne, dlaczego Hinton, który pochodzi z wielkiej Brytanii, przeniósł się tutaj w 1980 po pracy na Uniwersytecie Carnegie — Mellon university w Pittsburghu.

Może nie na samym początku rewolucji

Toronto — czwarty co do wielkości miasto w ameryce Północnej (po Mexico city, Nowym Jorku i Los Angeles), a już na pewno bardziej zróżnicowane: ponad połowa ludności był urodzony poza granicami Kanady. I to widać, kiedy chodzisz po mieście. Wielonarodowy tłum. Istnieje bezpłatna służba zdrowia i dobre szkoły, ludzie przyjaźni, polityki w stosunku lewica i stabilne; wszystko to przyciąga ludzi jak Hinton, który mówi, że wyjechał z USA ze względu na "Ирангейта" (Iran-contra — wielki polityczny skandal w USA w drugiej połowie lat 1980-tych; wtedy dowiedział się o tym, że poszczególni członkowie administracji USA zorganizowali tajne dostawy broni do Iranu, łamiąc tym samym broń embargo wobec tego kraju). Od tego zaczyna się nasza rozmowa przed obiadem.

", Wiele osób uważało, że STANY zjednoczone mogą zaatakować w Nikaragui", mówi. "Oni jakoś wierzyli, że Nikaragua należy do USA". Opowiada, że niedawno zrealizował wielki przełom w projekcie: "Ze mną zaczął pracować bardzo dobry młodszy inżynier", kobieta o imieniu Sara Sabur. Sabur z iranu, i jej odmówiono mu wizy do pracy w USA. Biuro Google w Toronto wyciągnął ją.

Хинтону 69 lat. Ma ostre, chude angielskie twarz z delikatnym ustami, wielkimi uszami i dumnym nosem. Urodził się w Wimbledonie i w rozmowie przypomina narratora dziecięcej książki o naukę: ciekawy, завлекающий, stara się wszystko wyjaśnić. Jest zabawny i trochę gra na publiczność. Boli go siedzieć z powodu problemów z plecami, więc latać nie może, a na wizycie u dentysty kładzie się na przyrząd, przypominający deskę.

W 1980 Hinton, jak i teraz, ekspertem w sieciom neuronowym sieci, znacznie uproszczonego modelu sieci neuronów i synaps w mózgu. Jednak w tym czasie był mocno postanowiono, że sieci neuronowe — ślepy zaułek w badaniach AI. Choć pierwsza sieć neuronowa "Перцептрон" został opracowany w latach 1960-tych i jej uważali, że pierwszym krokiem w kierunku maszynowego intelektu ludzkiego poziomu, w 1969 roku Marvin Мински i Seymour Паперт matematycznie udowodnione, że takie sieci mogą wykonywać tylkonajprostsze funkcje. U tych sieci były tylko dwie warstwy neuronów warstwy wejściowej i warstwa wyjścia. Sieci z dużą liczbą warstw między neuronami wejścia i wyjścia mogą, w teorii, rozwiązać szeroki zakres problemów, ale nikt nie wiedział, jak ich szkolić, tak że w praktyce były one bezużyteczne. Z powodu "Перцептронов" od pomysłu do sieci neuronowych odmówił prawie wszystko poza kilkoma wyjątkami, w tym Hintona.

Przełom Hintona w 1986 roku polegała na tym, aby pokazać, że metoda odwróconej dystrybucji błąd może szkolić głęboką sieć neuronową z ilością warstw więcej niż dwóch lub trzech. Ale potrzeba było jeszcze 26 lat, zanim wzrosła moc obliczeniowa. W artykule 2012 roku Hinton i jego dwóch studentów z Toronto wykazały, że głębokie sieci neuronowe, przeszkoleni z zastosowaniem бэкпропа, wyprzedzili najlepsze systemy rozpoznawania obrazów. "Głębokie szkolenie" nabrały tempa. Świat w jednej chwili zdecydował, że od rana AI zdobędzie władzę. Dla Hintona to był długo oczekiwany zwycięstwo.

Pole zniekształcenia rzeczywistości

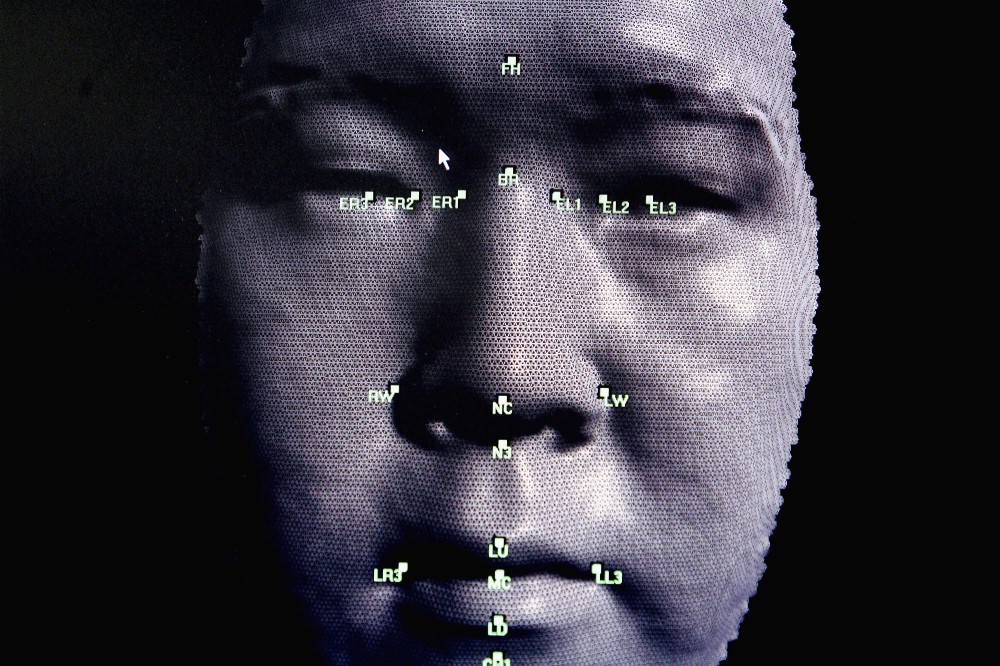

Sieć Neuronowa jest zwykle przedstawiana jako kanapkę, warstwy którego nałożone na siebie. Warstwy te zawierają sztuczne neurony, które w swej istocie są prezentowane małymi jednostkami obliczeniowymi, które aktywują się — jak podekscytowany prawdziwy neuron — i przekazują to emocje do kolejnych neuronów, z którymi są połączone. Pobudzenie neuronu przedstawione liczby, powiedzmy 0.13 lub 32.39, która określa stopień pobudzenia neuronu. I jest jeszcze inna ważna liczba, na każdym z połączeń między dwoma neuronami, która określa, ile podniecenia powinno być przekazywane od jednego do drugiego. Liczba ta modeluje życie synaps między neuronami w mózgu. Im wyższa liczba, tym silniejszy jest związek, a więc więcej wzbudzenia płynie od jednego do drugiego.

Jednym z najbardziej udanych zastosowań głębokich sieci neuronowych stało się rozpoznawanie obrazów. Dziś istnieją programy, które potrafią rozpoznać, czy na zdjęciu hot-doga. Jakieś dziesięć lat temu były niemożliwe. Aby zmusić je do pracy, najpierw trzeba zrobić zdjęcie. Dla uproszczenia powiedzmy, że jest to obraz czarno-biały 100 na 100 pikseli. Można скармливаете jego neural network, ustanawiając wzbudzenia każdego modelowanego neuronu do otwarcia warstwie tak, że ono będzie równa jasności każdego piksela. To dolna warstwa kanapki: 10 000 neuronów (100 x 100), reprezentujące jasność każdego piksela na obrazie.

Następnie ten wielki warstwy neuronów podłączeniu do innego dużej warstwy neuronów, już powyżej, powiedzmy, kilku tysięcy, a ich z kolei do innej warstwy z kilku tysięcy neuronów, ale już mniej i tak dalej. Wreszcie, górna warstwa kanapki — warstwa wyjścia — składać się będzie z dwóch neuronów — jednego reprezentującego "hot-dog", a drugiego — "nie hot-dog". Pomysł w tym, aby nauczyć sieć neuronową podniecać tylko pierwszy z tych neuronów, jeśli na zdjęciu jest hot-dog, i drugi, jeśli nie. Бэкпроп, metoda odwróconej dystrybucji błędy, na którym Hinton zbudował swoją karierę, właśnie to robi.

Бэкпроп jest bardzo prosta, choć najlepiej działa z ogromną ilością danych. Dlatego duże dane są tak ważne dla AI — dlaczego się nimi z zapałem zajmują się Facebook i Google i dlaczego Vector Institute postanowił nawiązać łączność z czterema największymi szpitalami Kanady i wymianę danych.

W tym przypadku dane przyjmują formę milionów zdjęć, niektóre z hot-dogami, niektóre bez; rzecz w tym, aby oznaczyć te zdjęcia jak ma hot-dogi. Kiedy tworzysz sieć neuronową po raz pierwszy, połączenia między neuronami są losowe wagi – losowe liczby, które mówią, ile podniecenia przekazywane przez każde połączenie. Jakby synapsy w mózgu nie zostały jeszcze skonfigurowane. Celem бэкпропа — zmiany te wagi tak, aby sieć działała: więc, gdy wyślesz zdjęcie hot-doga na najniższą warstwę, neuron "hot-doga" w górnej warstwie podekscytowany.

Załóżmy, że bierzesz pierwszą szkoleniową obraz z wizerunkiem pianinie. Przekształcisz intensywność pikseli obrazu 100 x 100 do 10 000 liczb, po jednej na każdy neuron warstwy dolnej sieci. W miarę tego, jak pobudzenie rozprzestrzenia się za pośrednictwem sieci, zgodnie z siłą połączenia neuronów w sąsiednich warstwach, wszystko stopniowo dochodzi do ostatniej warstwy, jednego z dwóch neuronów, które określają, jest na zdjęciu hot-doga. Ponieważ jest to obraz z fortepianu, neuron "hot-doga" powinien pokazać zero, a neuron "nie hot-doga" powinien pokazać liczba wyżej. Załóżmy, że wszystko działa nie tak. Załóżmy, że sieć pomyliła się co do obrazu. Бэкпроп — jest to zabieg wzmocnienia siły każdego połączenia w sieci, który umożliwia naprawić błąd w powyższym przykładzie uczenia się.

Jak to działa? Zaczynasz z ostatnich dwóch neuronów i sprawdzacie, jak bardzo się mylą: jaka jest różnica między liczbami pobudzenia i jaka ona powinna być w rzeczywistości. Następnie przeglądasz każde połączenie, prowadzące do tych neuronów ruchowych — schodząc poniżej warstw — i określamy ich wkład w błąd. Nadal to robić, aż dojdziesz do pierwszego zestawu połączeń na samym dnie sieci. W tym momencie wiesz, jaki jest wkład poszczególnych związków w ogólny błąd. W końcu zmieniasz wszystkie wagi, aby w ogóle zmniejszyć szanse na błąd. Ten tak zwany "metoda odwróconej dystrybucji błąd" polega na tym, że jak by прогоняете błędów temu w sieci, począwszy od wstecznego końca, z wyjścia.

Niesamowite zaczyna się dziać, kiedy robisz to z milionami lub miliardami zdjęć: sieć zaczyna dobrze określić, przedstawiony na zdjęciu hot-doga, czy nie. I co jeszcze bardziejwarto zauważyć, to to, że poszczególne warstwy tych sieci rozpoznawania obrazów zaczynają "zobaczyć" obraz tak samo, jak to czyni nasz własny system wizualny. To jest pierwsza warstwa wykrywa kontury — neurony aktywują się, gdy obwody są, i nie aktywują się, gdy ich nie ma; następna warstwa określa zestawy obwodów, na przykład, kąty; następna warstwa zaczyna rozróżniać formy; następna warstwa znajduje się w różnego rodzaju przedmioty, takie jak "otwartej bułeczki" lub "zamknięty bułeczki", bo są aktywowane odpowiednie neurony. Sieć organizowane są w hierarchiczne warstwy, nawet nie będąc zaprogramowaną w ten sposób.

Prawdziwa inteligencja nie trwoży, gdy problem jest nieco inny.

Dokładnie tak to wszystkich zaskoczyło. Chodzi nie tyle w tym, że sieci neuronowe dobrze klasyfikują zdjęcia z hot-dogami: budują reprezentacji pomysłów. Z tekstem to staje się jeszcze bardziej oczywiste. Można oddać tekst Wikipedii, wiele miliardów słów, prosty neural network, ucząc ją upoważnić każde słowo liczbami odpowiadającymi возбуждениям każdego neuronu w warstwie. Jeśli wyobrazić sobie te wszystkie liczby współrzędnych w trudnej przestrzeni, można znaleźć punkt, znaną w tym kontekście jako wektor, dla każdego słowa w tym miejscu. Następnie kształci się sieć tak, że słowa, które pojawiają się obok na stronach Wikipedii, będzie dzielące podobne współrzędnych — i voila, dzieje się coś dziwnego: słowa, które mają podobne wartości, będą wyświetlane obok siebie w tej przestrzeni. "Szalony" i "smutne" będą obok; "trzy" i "siedem" też. Ponadto, ilustracja arytmetyka pozwala odjąć wektor "Francji" z "Paryża", dodaj go do "Włoch" i znaleźć "Rzym" w pobliżu. Nikt nie mówił нейросети, że Rzym do Włoch — to, że Paryż jest dla Francji.

"To jest niesamowite", mówi Hinton. "To szokujące". Sieci neuronowe można traktować jako próbę wziąć rzeczy — obrazy, słowa, nagrania rozmów, dane medyczne — i umieścić je w, jak mówią matematycy, wielowymiarową przestrzeń liniowa, w którym bliskość lub oddalenie rzeczy będzie odzwierciedlać najważniejsze aspekty prawdziwego świata. Hinton uważa, że właśnie to sprawia, że mózg. "Jeśli chcesz dowiedzieć się, co to jest myśl — mówi — mogę przesłać ci ją serią słów. Mogę powiedzieć: "John pomyślał: "ups". Ale jeśli zapytacie: co to jest myśl? Co to znaczy dla Johna mieć tę myśl? Przecież w jego głowie nie ma otwieranych cudzysłowu, "ups", upadających cudzysłowu, wcale tak blisko nie jest. W jego głowie przebiega jakaś aktywność neuronowa". Duże obrazy neuronal aktywność, jeśli matematyk, można łapać w wektor przestrzeni, gdzie aktywność każdego neuronu będzie odpowiadać liczbie, a każda liczba — współrzędnej bardzo dużej wektor. Zdaniem Hintona, myśl — to taniec wektorów.

Teraz rozumiem, dlaczego Instytut Wektor nazwali tak?

Hinton stwarza pewne pole zniekształcenia rzeczywistości, jest przekazywana poczucie pewności i entuzjazmu, najokropniejsze wiarę w to, że dla wektorów nie ma rzeczy niemożliwych. W końcu oni już stworzyli autonomiczne samochody, które wykrywają raka komputery, tanie tłumacze języka mówionego.

I tylko wtedy, gdy wychodzisz z pokoju, wspomina pan, że te systemy "głębokiego uczenia się" nadal jest dość głupi, pomimo swojej демонстративную siłę myśli. Komputer, który widzi kilka pączków na stole i automatycznie podpisuje ją jako "stos pączków, leżących na stole", wydaje się być wyrozumiały świat; ale gdy ten sam program widzi dziewczynę, która czyści zęby, i mówi, że to "chłopiec z kijem baseballowym", zdajesz sobie sprawę, jak nieuchwytny to zrozumienie, jeśli ono w ogóle istnieje.

Sieci Neuronowe — to po prostu bezmyślne i niejasne aparaty rozpoznawania obrazów, i jak przydatne mogą być takie aparaty rozpoznawania obrazów — ponieważ starają się zintegrować w dowolne oprogramowanie — w najlepszym razie stanowią ograniczoną rasy inteligencji, którą łatwo oszukać. Głęboka sieć neuronowa, która rozpoznaje obrazy, może być w pełni сконфужена, jeśli zmienisz jeden piksel lub dodać wizualny szum, niezauważalne dla człowieka. Prawie tak samo często, jak możemy znaleźć nowe sposoby zastosowania głębokiej nauki, tak często mamy do czynienia z ograniczonością. Autonomiczne samochody nie mogą jeździć w warunkach, których nie widział. Maszyny nie mogą demontować oferty, które wymagają zdrowego rozsądku i zrozumienia tego, jak działa świat.

Głębokie uczenie się w pewnym sensie naśladuje to, co się dzieje w ludzkim mózgu, ale powierzchownie, możliwe, że to wyjaśnia, dlaczego jego inteligencja jest taki powierzchowny czasami. Бэкпроп nie został wykryty w trakcie nurkowania w mózg, próbuje rozszyfrować samą myśl; dorastał z modeli uczenia się zwierząt metodą prób i błędów w starej eksperymentach. I większość ważnych kroków, które zostały wykonane od momentu jego pojawienia się, nie zawiera nic nowego na temat neurobiologii; były to poprawki techniczne, co przez lata pracy matematyków i inżynierów. To, co wiemy o inteligencji, to nic w porównaniu z tym, czego o nim jeszcze nie wiemy.

David Дювенод, asystent profesora z tego samego oddziału, że i Hinton, na Uniwersytecie w Toronto, twierdzi, że głębokie uczenie to na inżynierię przed wprowadzeniem fizyki. "Ktoś pisze pracę i mówi: "zrobiłem ten most, i stoi!". Inny pisze: "zrobiłem ten most, i upadł, ale dodałem podpory i stoi". I wszyscy szaleją na podporach. Ktoś dodaje łuk — i wszystkotakie: łuki to jest fajne! Z fizyki można właściwie zrozumieć, co działa i dlaczego. Dopiero niedawno zaczęły przenosić się do przynajmniej jakiegoś zrozumienia sztucznej inteligencji".

I sam Hinton mówi: "Na większości konferencji mówią o wprowadzeniu niewielkich zmian, zamiast tego, aby dokładnie przemyśleć i zadać pytania: "Dlaczego to, co robimy teraz, to nie działa? Z czym to jest związane? Skupmy się na tym".

Spojrzenie od strony trudno sporządzić, gdy wszystko, co widzisz — to promocja za promocją. Ale najnowszy postęp w dziedzinie AI w mniejszym stopniu był naukowym, a w większym — budynkiem. Chociaż staliśmy się lepiej zrozumieć, jakie zmiany poprawią system głębokiego uczenia się, jeszcze niejasno przedstawiamy, jak te systemy działają i czy mogą kiedyś się w coś tak potężne, jak ludzki umysł.

Ważne jest, aby zrozumieć, czy mogliśmy wydobyć wszystko, co można, z бэкпропа. Jeśli tak, to czeka nas płaskowyżu w rozwoju sztucznej inteligencji.

Cierpliwość

Jeśli chcesz zobaczyć następny przełom, coś w rodzaju podstawy do maszyn o znacznie bardziej elastyczne inteligencją, należy, w teorii, odwołać się do badań, jak badanie бэкпропа w latach 80-tych: gdy mądrzy ludzie poddaliśmy się, bo ich pomysły na razie nie pracowali.

Kilka miesięcy temu byłem w Center for Minds, Brains and Machines, многоцелевом instytucji, расквартированном w MIT, aby zobaczyć, jak mój przyjaciel Эял Дехтер chroni swoją pracę dla kognitywistyki. Przed rozpoczęciem występu jego żona Amy, jego pies Ruby i jego córka Susanna poparli go i życzył powodzenia.

Эял zaczął swoje przemówienie z ekscytującej pytania: jak to się stało, że Suzanne, która zaledwie dwa lata, nauczyłam się rozmawiać, grać, śledzić opowieściami? W mózgu ludzkim takiego, co pozwala mu tak dobrze się uczyć? Nauczy się, czy komputer kiedyś uczyć się tak szybko i płynnie?

Rozumiemy nowe zjawiska z punktu widzenia rzeczy, które rozumiemy. Łamiemy domena na kawałki i uczymy się go na części. Эял — matematyk i programista, myśli o zadaniach, na przykład, zrobić suflet — jak o skomplikowanych programach komputerowych. Ale przecież nie dowiedz się, jak zrobić suflet, заучивая setki drobnych instrukcji programu jak "obrócić kolanko na 30 stopni, a następnie spójrz na blat, a następnie podnieś palec, a następnie...". Jeśli by trzeba było to robić w każdym nowym przypadku, szkolenie byłoby nie do zniesienia, i zatrzymali się w rozwoju. Zamiast tego widzimy w programie kroki najwyższej klasy, jak "ubić białka", które same w sobie składa się z субпрограмм jak "rozbić jajka i oddzielić białka od żółtek".

Komputery tego nie robią i dlatego wydają się śmieszne. Aby system głębokiego uczenia się przez hot-dog, trzeba nakarmić jej 40 milionów obrazów hot-dogów. Чтоюы Susan dowiedziała się hot-doga, po prostu pokaż jej hot-doga. I na długo przed tym u niej pojawi się zrozumienie języka, który idzie znacznie głębiej rozpoznania występowania poszczególnych słów razem. W przeciwieństwie do komputera, w jej głowie jakieś wyobrażenie o tym, jak działa świat. "Dziwi mnie, że ludzie boją się, że komputery zabrać od nich pracę", mówi Эял. "Komputery mogą zastąpić prawników nie dlatego, że prawnicy robią coś skomplikowanego. A dlatego, że prawnicy słuchają i rozmawiają z ludźmi. W tym sensie jesteśmy bardzo daleko od tego wszystkiego".

Prawdziwa inteligencja nie смутится, jeśli lekko zmienić wymagania dotyczące rozwiązania problemu. I kluczową tezą Эяла była demonstracja tego, w zasadzie, jak zmusić komputer do pracy w ten sposób: już stosować wszystko, co on już wie, do nowych wyzwań, szybko uchwycić w locie, by stać się ekspertem w zupełnie nowej dziedzinie.

W istocie, jest to procedura, którą nazywa algorytmem "badania kompresji". Daje komputerowi funkcję programisty, gromadzi biblioteki wielokrotnego użytku modułowych elementów, który pozwala na tworzenie bardziej skomplikowanych programów. Nie wiedząc nic o nowej domenie, komputer próbuje uporządkować wiedzę o nim, po prostu ucząc się go, łącząc wykryta i dalej studiuje, jak dziecko.

Jego doradca, Joshua Tenenbaum, — jeden z najbardziej cytowanych badaczy AI. Nazwa Тененбаума всплывало w połowie rozmów, które miałem z innymi naukowcami. Niektóre z kluczowych osób w DeepMind — zespołu AlphaGo, legendarny który pokonał mistrza świata w grze w go w 2016 roku — pracowali pod jego rozpoczęciem. Jest zaangażowany w starcie, który stara się dać samorządową samochodów intuicyjne zrozumienie podstaw fizyki i intencji innych kierowców, aby te lepiej предвосхищали, co dzieje się w sytuacjach, z którymi nie spotkali się wcześniej.

Teza Эяла dopóki nie zastosowano w praktyce, nawet w programie nie podano. "Problemy, nad którymi pracuje Эял, bardzo, bardzo skomplikowane", mówi Tenenbaum. "Trzeba by minęło wiele pokoleń".

Kiedy usiedliśmy do niej na kawę, Tenenbaum powiedział, że bada historię бэкпропа dla inspiracji. Przez dziesięciolecia бэкпроп był przejawem fajny matematyki, w przeważającej części na nic się nie stanie. W miarę jak komputery stawały się coraz szybciej, a technika trudniejsze, wszystko się zmieniało. Ma nadzieję, że coś takiego się stanie z jego własną pracą i pracami uczniów, ale to może potrwać jeszcze kilka lat".

Jeśli chodzi o Hintona, jest on przekonany, że pokonywanie ograniczeń AI związane z utworzeniem "mostu między informatyką i biologią". Бэкпроп, z tego punktu widzenia, był triumfem biologicznie inspirowanych obliczeń; pomysł początkowo wyszła nie z inżynierii, a zpsychologii. Dlatego teraz Hinton próbuje powtórzyć ten wyczyn.

Dzisiaj sieci neuronowe składają się z dużych płaskich warstw, ale w неокортексе człowieka prawdziwe neurony ustawiają się nie tylko w poziomie ale i w pionie, w kolumny. Hinton wie, do czego służą te kolumny — w widzeniu, na przykład, pozwalają one rozpoznawać obiekty nawet po zmianie punktu widzenia. Dlatego, że tworzy sztuczną wersję — i nazywa je "kapsułki" — w celu sprawdzenia tej teorii. Póki co nic nie wychodzi: kapsułki nie jest szczególnie poprawić wydajność sieci. Ale przecież 30 lat temu z бэкпропом było to samo.

"To musi się udać", mówi on o teorii kapsułki, śmiejąc się z własnej brawury. "A to, że na razie nie działa, to tylko tymczasowe podrażnienie".

Na podstawie materiałów Medium.com

Bardziej:

Czy melatonina może pomóc w leczeniu koronawirusa?

Niektórzy lekarze uważają, że hormon snu pomaga w koronawirusie Wydaje się, że na liście potencjalnych metod leczenia COVID-19, które naukowcy zaproponowali na kilka miesięcy pandemii, innego uzupełnienia: melatoniny. Lekarz w Teksasie mówi, że już l...

W jakich krajach mieszkają najbardziej aktywni ludzie?

W jakich krajach ludzie więcej chodzą i uprawiają sport? Przekonajmy się. Aktywność fizyczna, wraz z prawidłowym odżywianiem, jest uważana za jeden z głównych czynników zdrowego stylu życia. Liczne badania naukowe wykazały, że regularne ćwiczenia i c...

Co to jest "hormon miłości", a kto go brakuje?

Oksytocyna - hormon miłości Organizm ludzki wytwarza ogromną różnorodność hormonów, z których każdy wykonuje swoje zadanie. Na przykład, wiele znanych endorfin przynieść ludziom poczucie radości, i nadmiar kortyzolu sygnalizuje stresujący stan osoby....

Nowości

Chińskie roboty-naukowcy polecą na Księżyc zamiast ludzi

Wszystkie prace badań Księżyca będą odbywać się w trybie automatycznym, — China Daily", powołując się na dostarczone przez wysokiej rangi urzędnika CHRL informacji. Program badania Księżyca, w tym lądowanie луноходов i prace...

DARPA inwestuje 100 milionów dolarów w rozwój genetyczny broni

Jak informuje gazeta "the Guardian", Zarządzanie obiecujących projektów badawczych w USA (DARPA) przystąpiło do opracowania broni na podstawie inżynierii genetycznej. Do pracy nad projektem urząd przeznaczył 100 milionów dolarów. ...

Bakterie mogli przekształcić w nano

Нанороботы może bardzo się przydać do różnych rzeczy: za ich pomocą można było przeprowadzać operacje, zwiedzić niedostępne wcześniej miejsca, przeprowadzać diagnostykę organizmu i dostarczać leki w określone miejsca ciała ludzkie...

Naukowcy dodali dwie nowe litery w kod genetyczny

Jak wiadomo, aby zakodować ogromna ilość informacji w kodzie genetycznym, używany tylko 4 nukleinowych kwasy: adenina, guanina, tymina i cytozyna. W kodzie genetycznym są one oznaczone odpowiednimi literami — A, G, T i C. w ...

Choroby będą identyfikować, tylko skanowania siatkówki

Okresowa diagnostyka i badania profilaktyczne pozwalają wykryć wiele chorób na wczesnym etapie, ale niektóre stany mogą być diagnozowane dopiero wtedy, gdy choroba jest już dość długo. Ponadto, wiele жизнеугрожающие patologii nie ...

Powstała pierwsza syntetyczny bakteria z imitacji DNA

Całe życie biologiczne na Ziemi opiera się na czterech nukleinowych (azotowych) podłożach DNA: A, T, C i G (adenina, cytozyna, tymina i guanina). Ale co będzie, jeśli człowiekowi uda się stworzyć nowe sztuczne nukleinowych podstaw...

Astronomowie odkryli 72 nowe galaktyki

Dzięki zastosowaniu nowego instrumentu naukowego MUSE (Multi Unit Spectroscopic Explorer), zainstalowanej na Bardzo duży teleskop (VLT) Europejskiego obserwatorium południowego w Chile, astronomowie mogli odkryć 72 nowe galaktyki....

Ziemne robaki są w stanie żyć i rozmnażać się w marsjańskim gruncie

Bardzo ciekawy eksperyment przeprowadzili pracownicy w Holandii. Oni zażądali od amerykańskiej agencji kosmicznej NASA kopię , odtworzone na podstawie danych uzyskanych w trakcie kilku marsjańskich misji, a następnie umieścili w t...

Astronomowie odkryli egzoplaneta z pozycjonerami okresem 27 000 lat

Każda planeta naszego układu Słonecznego ma znacznie różni się od pozostałych pozycjonerami okres obrotu wokół Słońca. Na przykład, jeśli jeden obrót Ziemi wokół gwiazdy trwa 365,25 dnia, to u tego samego Marsa to zajmuje prawie d...

Sztuczna inteligencja będzie zanurzyć się w świat cząsteczek w poszukiwaniu niesamowitych leków

w środku Ciemnej nocy, z dala od miejskiego światła, gwiazdy Drogi Mlecznej wydają się być niezliczone. Ale z dowolnego miejsca невооруженному oka widać nie więcej niż 4500 gwiazdek. W naszej galaktyce jest ich 100-400 miliardów g...

Naukowcy odkryli, jak różne rodzaje alkoholu wpływają na emocje

nie jest tajemnicą, że alkohol jest bezpośrednio związany z stanem emocjonalnym człowieka. Komu to unosi się nastrój, a kogoś, wręcz przeciwnie, dołuje. Kogoś alkohol wyzwalające, a kogo-to sprawia, że bardziej agresywny i задирис...

Jak zwiększyć możliwości mózgu?

Wiadomo, że w miarę starzenia się wszystkie rezerwy naszego organizmu są na wyczerpaniu, a narządy i tkanki zaczynają stopniowo утрачивать swoją funkcję. Według licznych badań, po 40 latach objętość mózgu człowieka zmniejsza się ś...

Czy materia może opuścić horyzont zdarzeń podczas scalania czarnych dziur?

Jak tylko znajdziesz się w horyzont zdarzeń czarnej dziury, już nigdy go nie opuścisz. Nie ma prędkości, którą można było zdobyć, nawet prędkość światła, aby pozwoliła ci wyjść. Ale w ogólnej teorii względności przestrzeń zakrzywi...

U amiszów odkryli mutację, zwycięskie cukrzyca, a nawet starzenie się

Амиши, znane również jako аманиты, — to wspólnota religijna, mieszkająca w kilku stanach USA i w Kanadzie. Амиши charakteryzują się prostotą życia, ubrania, niechęć do podejmowania większą część nowoczesnych technologii i ud...

Pierwszy wybuch w Czarnobylu był jądrowej, uważają naukowcy

Wypadek w ELEKTROWNI jądrowej w Czarnobylu, co wydarzyło się 26 kwietnia 1986 roku, stał się jednym z najbardziej przerażających w historii ludzkości. Wcześniej uważano, że wybuch w czwartym bloku energetycznym doszło dlatego, że ...

W Nowej Zelandii zaproponowali walczyć ze zwierzętami-szkodników za pomocą CRISPR

Technologia genetycznego edycji CRISPR znajduje coraz więcej różnych zastosowań. W Nowej Zelandii, na przykład, postanowił z jej pomocą pozbyć się gryzoni i innych szkodników. Myszy, поссумы, szczury i inne gryzonie powodują Nowej...

W Chinach chcą zbudować prom kosmiczny z silnikiem atomowym

W nowym raporcie, opublikowanym Chińskiej korporacji przemysłu lotniczego nauki i techniki (CASC), dedykowanego programu kosmicznego Chin, zawiera wiele ambitnych zadań, które Firma stawia przed sobą na najbliższe 20 lat. O niektó...

Przewidzieć, jak pójdzie ewolucja ludzi, nie można

Wszyscy wiemy, jak wyglądały neandertalczycy: wystające łuki brwiowe, gruby nos, wydłużona czaszka, potężna struktura kości i, prawdopodobnie, rude włosy i piegowate skóra. Być może krzywo посматриваете na rude, kiedy spotkać w me...

Naukowcy odkryli kolejną obiecującą земплеподобную planetę

Zaledwie 11 lat świetlnych od układu Słonecznego astronomowie odkryli nową землеподобную planetę z klimatem, który rzekomo może podchodzić do życia. Należy zauważyć, że po Проксимы b to druga najbliższa nam экзопланета, z taką cec...

13 naukowo potwierdzonych oznak tego, że jesteś mądrzejszy niż ci się wydaje

Wszyscy chcą wydawać skromniejsze. "Kto jest mądry? Ja? Nie, mam po prostu szczęście..." Wynika to chyba przede wszystkim z tym, że większość z nas nie chce być przedmiotem uwagi lub czyichś uprzedzeń. Oczywiście, są i tacy, którz...

Uwaga (0)

Ten artykuł nie ma komentarzy, bądź pierwszy!