你会立刻知道,你的色情。 你会明白的计算机?

Source:

Source:

<在开始的最后一个月、汤宣布,它将禁止色情。 当一个新的政策有关的内容生效,后约两个星期—月17—它已经成为明显的是,会有问题。 后部署的人工智能系统,这是perebanit所有的色情网站上,它错误地标记无辜的员额455,4万博客网站上之168,2亿员额:花瓶、女巫、鱼等等。

<<跨id="更308602">

<承认色情制品问题的一部分。 标识是一种相对简单的任务于人类,但更难以教导一个算法承认的细微差别。 确定的阈值,当过滤器的标记图象作为色情或不是色情,也是具有挑战性,部分是数学的。

<人工智能是一个不完美的镜子,我们如何看世界,只是为色情制品问题是一个反思发生什么事的人们之间,当他们是孤独的。 它有一定的道理,但是完整的画面不是。

<不要忘了订阅。

的人工智能

<虽然目前还不清楚什么是自动过滤器使用的空或者已经创建了自己的公司没有回应查询关于这个主题很明显,社会网络是坚持他自己的政策和技术。 例如,不一致的位置的网站关于"妇女表示的乳头"和艺术裸体,例如,导致上下文的解决方案,这证明,即使是棒的不知道什么禁止在平台上。 作为公司的一部分,以确定它认为淫秽吗? <第一,以阻断高风险的内容是很困难的,因为它最初是难以确定它是什么。 定义的淫秽—熊陷阱,这是超过一百年,在1896年美国率先通过法律调节淫秽。 在1964年在Jacobellis对俄亥俄州有关是否一个俄亥俄州禁止筛选的路易斯马勒,最高法院发出的也许是最有名的定义的难色情制品的今天:"我今天不试图进一步界定这种材料,其中,因为我的理解是,将包括在描述;以及也许我永远不可能成功的理解地做到这一点,"法官Stewart。 "但我知道它是什么,当你看到的电影与此相关联的情况下,它不是。" <机学习算法在同样的问题。 这就是问题所在试图解决布莱恩Delorge,首席执行官Picnix,一家公司,销售专门的人工智能技术。 他们的产品之一—虹膜—是一个应用程序上的客户方,其用于发现色情制品问题是"帮助人民",说DeLong,"谁不想要的色情在我的生活。" 他注意到的另一个问题色情是,有可能是任何东西,很多不同的东西和图像那不是淫秽的,可能有一个类似的项目。 图像的方在海滩可能被阻止,不是因为它具有更多的皮肤比图片中的办公室,但是因为它是在边缘。 "这就是为什么它是很难培养的图像识别的算法一说,"隆的。 "当的定义变得困难的人计算机也面临困难"。 如果人们不能同意什么是色情什么不是,可以计算机在所有的希望知道区别? <以教AI检测色情,首先你需要做的就是给他的色情。 有很多色情制品。 我在哪里可以得到它? 好,第一件事情的人做的就是下一堆从此,维多斯纳马伊-超的,XVideos,说丹*夏皮罗,共同创始人一个启动Lemay的。ai,创建过滤器AI为他们的客户。 "它是一个灰色领域的法律性质,例如,如果你是研究的内容的其他人是否属于你"? <后的程序员都下载吨的色情,他们从录像片段,色情制品问题不是,要确保录像将不会导致阻止的比萨。 平台的支付人,大部分,在美国以外,对标记的这样的内容;工作报酬低和无聊,因为进入一个"验证"的。 他们只是坐在那里,说:这是色情的,就是这个。 过滤器具,因为所有的色情与标记。 学习更是如果使用不仅仅是图片,但大样本数据。 <"往往拥有不只是过滤色情,而是相关的材料,"Shapiro说。 "像假的档案照片中,女孩和电话。" 他是参考性工作者在寻找客户,但它可以是任何东西不是很合法的。 "这不是色情的,但这种事情你不要在平台上看到什么?"。 良好的自动化的主持人是经过训练的数以百万计—如果不是数以百万计—实例的内容,因此可以节省大量的人小时。 <"你可以把它比作之间的差别一个儿童和一个成年人说,"马特Zeiler,首席执行官和创始人Clarifai,启动在计算机领域的愿景,它实现了筛选的图像,用于企业客户。 "我可以告诉你肯定—一两个月前,我们有一个孩子。 他们什么都不知道的世界,对他们来说一切都是新的。" 你必须显示,儿童(算法)的东西很多,这是一些教训。 "数以百万计的例子。 但作为成人时,我们已经创建了所以很多方面对世界并了解它是如何工作的,我们可以学习新的东西,从仅仅是两个例子。" (是的,教AI过滤器成人内容的—这就像显示一个孩子有很多色情片的)。 今天,这样的公司Clarifai正在迅速增长。 他们有一个良好的数据库的世界,他们可以分辨出狗从猫穿着从赤裸裸的。 Celera公司使用其模式为培训新的算法为他们的客户—因为原型已经处理了很多数据、个人版本将需要一个新的数据集的工作。 <然而,算法是困难的这样做的权利。 与内容显然色情的,它处理好,但分类可能会错误地印记的公布内衣为禁忌,因为画面是更多的皮肤比,也就是说,该办公室。 (基尼和内衣,根据Celera,非常困难的)。 这意味着,那些参与标记应当注重这些极端的情况下在其工作,优先考虑的事实很难进行分类的模型。 <什么是最困难的? <"的动漫情色片,说:"Zeiler的。 "第一个版本的我们裸体探测器是不使用对于学习的卡通色情制品问题的"。 许多次艾混乱,因为我没有认识到无尽的。 "在这方面的工作,为一个客户,我们已经实施了很多他的数据模型和明显提高的精确度过滤器的卡通片,保持准确的真正的照片、说:"Zeiler. <的技术训练嗅出色情,它可以用在其他事情。 技术基础的这一系统是令人惊讶的是灵活的。 它比动画奶子 拼图从文字母,例如,被广泛用作一种自动的主持人审查在报纸上。 该软件适用同样的分类图像,除了一个事实,即各种各样的毒性,不裸体。 (毒性在文本的审查,以确定困难,因为色情的照片)。 Facebook使用一个类似的自动过滤检测自杀的消息和内容相关的与恐怖主义,并且他想使用这种技术来检测伪造新闻的其庞大的平台。 <所有这仍然取决于人的监督;我们更好地应对与模糊和不明确的上下文。 Zeiler说,他不认为他产品具有剥夺某个人的工作。 它解决了扩展问题的互联网。 人们仍然将培训AI、分类和标签内容,以便AI可以告诉大的差异。 <这是未来适度:个人、交钥匙工程方案提供通过这样做的公司自己的企业,在培训更多的复杂的分类的更多数据。 只是作为条和平方必须提供现成的支付解决方案的企业,不要处理它们的独立、创业像Clarifai,Picnix和Lemay的。ai提供线上节制。 <丹Shapiro从Lemay的。艾希望。 "如有任何新的技术,它仍然是进程中的发明。 所以我不认为我们失去了在发生故障的情况下". 但可以AI过独立行动没有监管的一个人吗? 它并不清楚。 "没有的小男人在烟壶,其过滤器的每一个镜头,"他说。 "我们需要获得的数据来自世界各地,以培养的算法"。建议

焦虑时,不是所有的作品,因为它应该,而是一个完全彻底改变,往往仍然仅是个人的道德准则,其中,像一个罗盘指示的方式。 但是什么引起的道德价值对一个人? 社会、亲人温暖、爱#8212;它是所有基于人类经验。 当你无法充分经验现实世界中,许多获得经验的书。 重温故事之后的故事,我们采取自己的内部框架,其中我们遵循多年。 在此基础上系统,研究人员决定进行一项实验,并灌输道德价值观的机,看看如果机器人可以区分善恶,阅读书籍和宗教的小册子。 的人工智能是创建不仅是为了简化程序的任务,而且要执行重要的和危险...

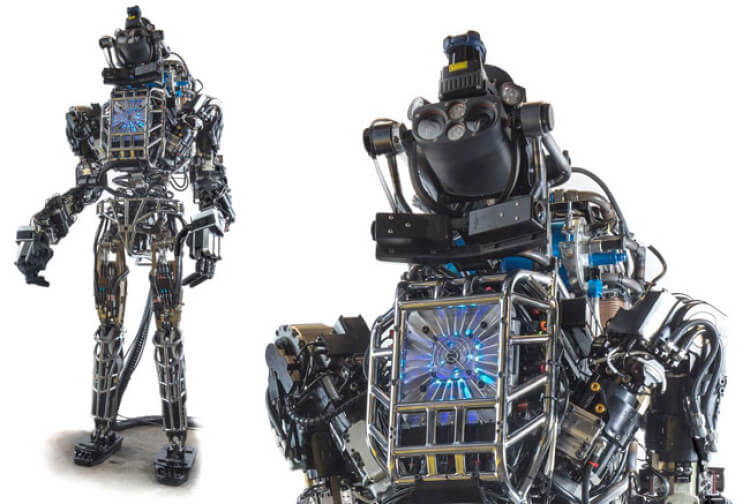

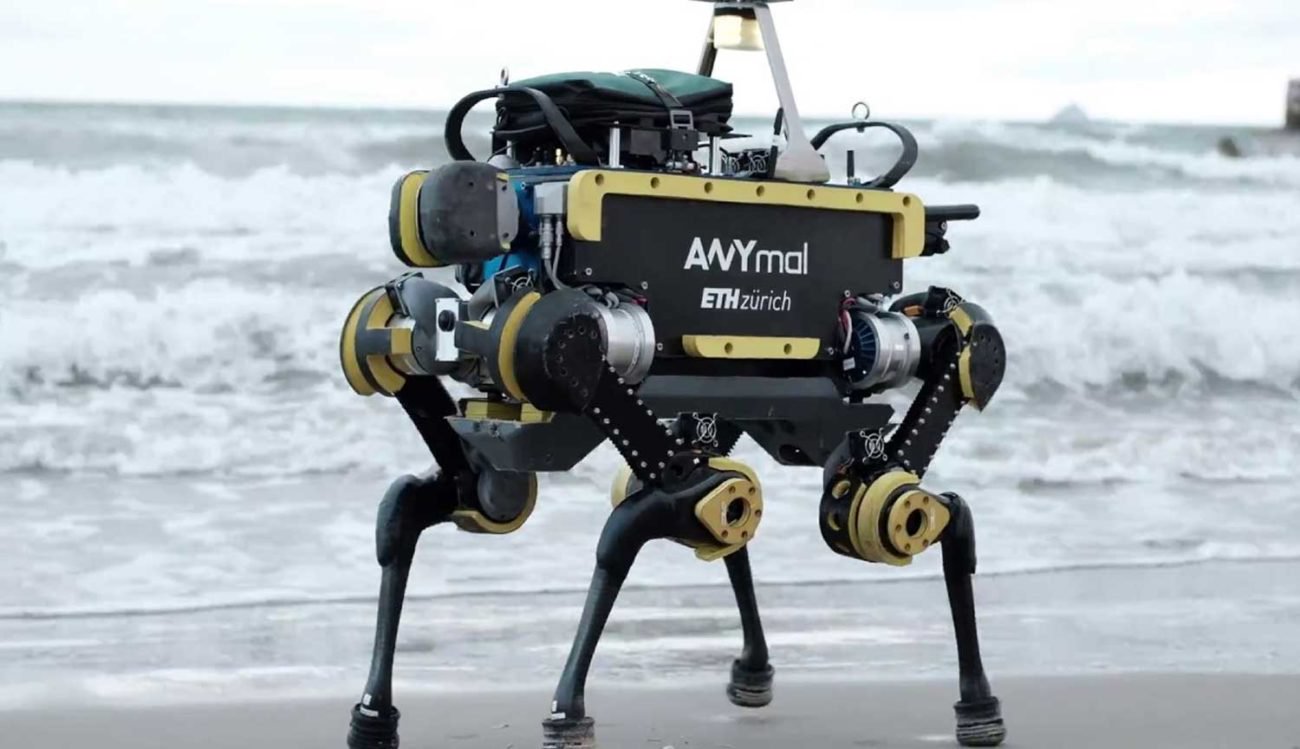

现在,当它涉及到机器人,看来没有人们想象镜头从"终结者"。 学会了使用机器人的良好社会,现在根据这一定义,躲不仅人形机器,也是那些仅仅能够实现自动化的一个进程或另一个。 巨大的工业机器人正在用于采矿企业、工厂、车会和家用电器,以及小其对应方定居在某些房子里。 但有最先进的机器人在地球上? 如果是这样,它看起来如何和工作的? 如何创造最为复杂的机器人 这个机器人是创造了近7年前,它是不断发展,到目前为止,还没有一个已经成功地超越. 机构为国防部高级研究项目,美国(国防部研究计划局)共同开发了人形...

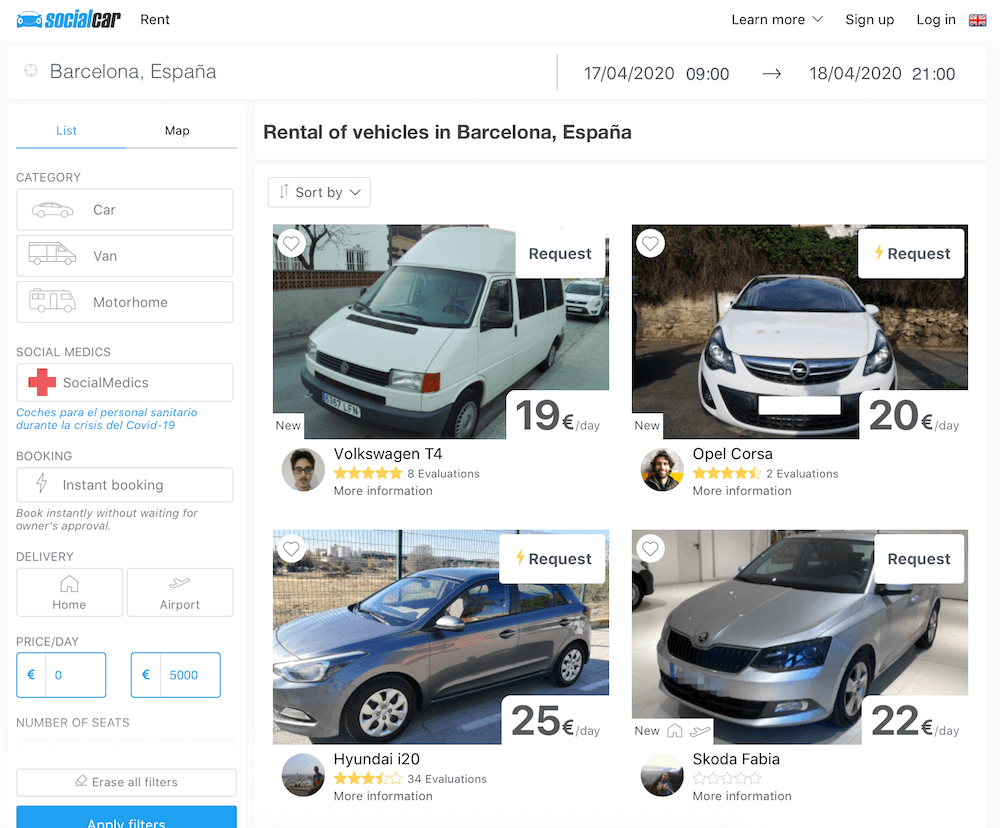

最近的伊隆麝香透露的秘密千年的摄像头上后视镜的车特拉斯模式3. 虽然主要目的的任何摄像机拍摄周围发生的事情,发现了一些细节。 因此,该相机将按照车辆的时刻,当它的工作原理在自动驾驶仪或租金,直到所需的主(麝香认为,这将是«排斥»的部分费用在购买车)。 其他的相机的功能:识别驱动程序(如果有多个)和自动调整的所有系统,以一个特定的人。 从座位和镜子所构成的气候系统。 特斯拉的发展是跨越式发展,被广泛使用的道路和汽车本身是能够跟停车场附近。 这是一个现实,我们阅读小说,一些5-1...

相关消息

...

...

...

...

评论意见 (0)

这篇文章已经没有意见,是第一个!