人们不相信大赦国际的。 如何解决它吗?

Source:

Source:

<人工智能已经能够预测未来。 警察利用它来生产的地图反映了当和有可能犯罪。 医生利用它来预测时,病人可以有一笔或一个心脏病发作。 科学家们甚至试图得到大赦国际的想象力,这样他可以预见的意外事件。

<<跨id="更282728">

<许多决定在我们的生活中需要良好的预测,并剂AI几乎总是做好他们不是人民。 然而,所有这些技术的进步,我们仍然缺乏信心预测,这给人工智能。 人们不用依靠大赦国际和更喜欢相信专家,在人们的面孔,甚至如果这些专家都是错误的。

<如果我们想要人工智能有益于人民,我们需要学会信任他。 为此,我们需要了解为什么人们如此坚持拒绝相信大赦国际的。

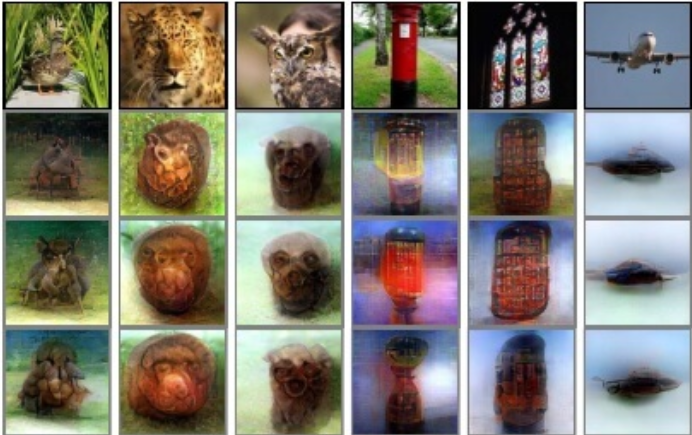

信任的医生的机器人

<试图通过IBM提供的超级计算程序的肿瘤学家(华生对于肿瘤学)已经非常怀念。 AI承诺提供高质量的咨询意见处理的12种类型的癌症,占80%的案例在世界上。 迄今为止,已有超过14 000患者接受的建议的基础上他的计算。 <但是当医生第一次遇到Watson,他们发现自己在一个相当困难的情况。 一方面,如果华森给了指示,关于处理、与他们自己的意见,医生没有看到非常有价值的建议。 超级计算机只是告诉他们什么他们已经知道,这些建议不会改变的实际治疗。 这可能会给医生心灵的和平和信心,在他们自己的决定。 但是IBM没有显示,Watson并提高存活率的癌症。 <另一方面,如果沃森已经提出了一些建议,从不同的专家,医生的结论华生无能。 和机器不能解释为什么治疗应工作,因为其计算机学习算法过于复杂能够理解的人。 因此,这导致更大的不信任,并且许多医生只是被忽略的建议AI,依靠自己的经验。 <结果的主要医疗合作伙伴的IBM Watson—MD*安德森癌症中心的最近报道的免除的程序。 丹麦医院还报告说,放弃该程序后,它发现肿瘤学家不同意Watson在两种情况下出的三. <问题的肿瘤Watson是,医生,他只是不信任。 人民的信任,往往取决于我们如何理解其他人的想法和经验加强了信心,他们的意见。 它创造了一种心理上的安全感。 AI,另一方面,一个相对较新的和令人困惑的事情的人。 他让决定的基础上复杂的系统分析,以确定潜在的隐藏的模式和微弱的信号而产生的大量数据。 <即使是可能的解释的技术语言、决策过程中的艾通常是太复杂,不能理解的大多数人。 相互作用的东西,我们不理解可能会导致焦虑和创造一种失去控制。 许多人根本不了解如何AI工作,因为它发生的地方幕后,在背景。 <于这个原因,他们更敏锐注意到的情况下,当AI犯了个错误:谷歌的算法,这klassificeret有色人种作为大猩猩;以聊天机器人Microsoft,这成为一个纳粹在不到一天;特斯拉的工作的自动驾驶仪,这出了车祸致命的结果。 这些不好的例子已经收到了不成比例的注意力的大众媒体,强调议程,我们不能依赖于技术。 机学习是不是100%可靠的,部分原因是因为他的设计人。该司的社会?

<的感觉的人工智能进行深入的性质的人。 最近,科学家们进行了一项实验在其中接受采访的人看电影关于人工智能的(奇幻),在主题的自动化在日常生活中。 它证明,无论是人工智能在电影描绘积极或消极的方式,仅仅是看电影表示我们的技术的未来极化的态度参与者。 乐观主义者甚至变得更加乐观,但是怀疑者被关闭,甚至更强。 <这表明,人们有偏见的针对大赦国际,开始从他们自己推理,是根深蒂固倾向的偏见确认:倾向于寻求或解释的信息,在这样一种方式来确认预先存在的概念。 因为大赦国际经常提到的在媒体,它可以促进深刻分裂的社会之间的分裂那些使用大赦国际,和那些拒绝它。 主要群组人可以获得一个严重的优势或障碍。三种方式出的信任危机AI

<幸运的是,我们必须思考如何处理的信誉。 一个只有经验AI可以显着提高人们的态度对这种技术。 还有证据表明,更经常使用的某些技术(如互联网),将更多的你信任。 <另一个解决方案将是开放的"黑箱"机械学习的算法和使其工作更加透明。 公司如谷歌,维和Twitter,已经发布透明度报告在政府的请求而公开的。 这种做法的人工智能系统将帮助人们得到正确理解的算法如何做出决定。 <研究表明,参与人在决策过程中的艾将会增加信心,并允许大赦国际的研究人类的经验。 该研究显示,人人都有机会略有修改的算法,感到非常满意地从他的工作的结果,显然是因为优越感和影响就未来的结果。 <我们没有必要了解复杂的内部运作的人工智能系统,但是如果你给人至少有一点信息和控制这些系统是实现,他们将有更多的信心和愿望,使大赦国际在日常生活中。建议

Dyslexia affects about 10% of the world's population There are many diseases in the world that are associated with disorders of the brain and spinal cord, as well as various groups of nerves. These diseases are called neurological disorders and one o...

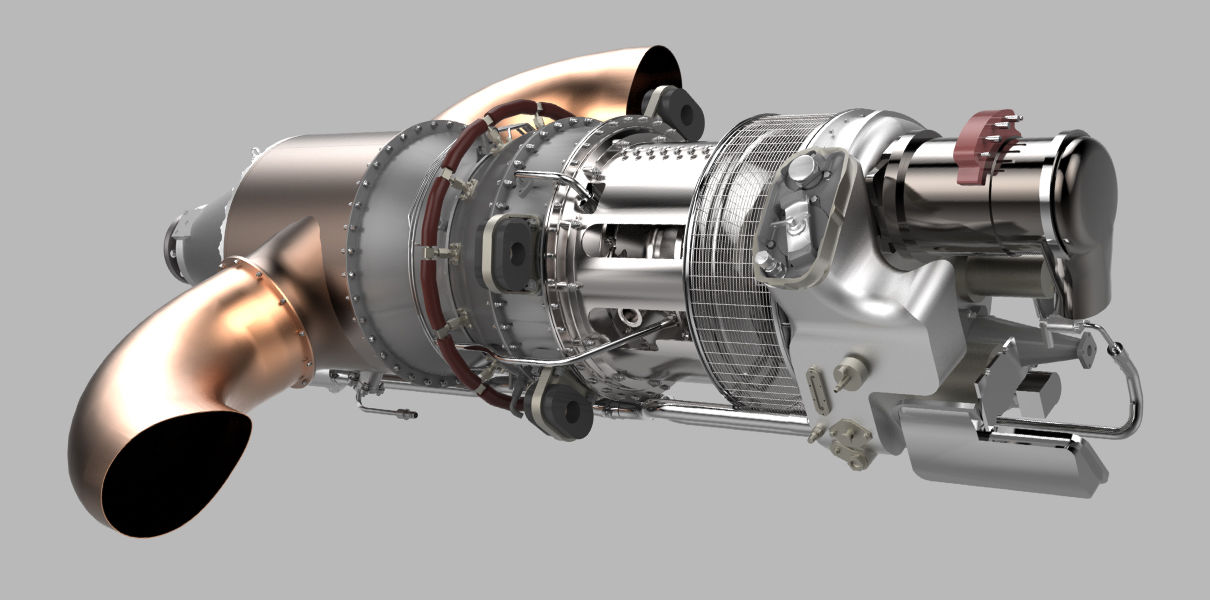

这种设计是不可能飞的速度几千公里每小时。 这需要其它的特征。 的现代飞机可以飞行速度非常快。 在«;快速»;我明白这不是速度快10倍的速度比的汽车,真的很快。 即使没有加力模式下,现代战斗机很容易克服的声音的速度。 一乘客的飞机已经飞行以超音速度。 它是可能的,但是昂贵的,所以(包括)的航班,并停止大约20年前。 一切都是好的,但是如果你深入的历史记录和档案文件,可以发现几架飞机,飞行不仅仅是超音速和高超音速,也就是几倍音速。 怎么可能发生什么事了他们和他们是否存在吗? 在结束时...

在互联网上出现的第一次审查在提供商粟米 美国企业家,伊隆*马斯(伊隆麝香)不仅涉及与制造的电动汽车和飞船。 在2015年,他创建公司粟米,其目的是确保互联网上的居民甚至最遥远的角落,我们的星球。 有成千上万的空间卫星互联网分布的村庄的居民将能够走向社会网络,并成为世界各地的用户。 在第一半,2020年,金额的粟米卫星在地球轨道超过500件,因此该公司决定启动该系统在测试模式。 互联网从伊隆*马斯可以从中受益的一些居民的美国和加拿大。 他们测量速度的上载和下载文件,并共享信息有关的延迟(平). 概...

相关消息

...

...

...

...

...

...

...

评论意见 (0)

这篇文章已经没有意见,是第一个!